70 milliards de paramètres en local, c'est lent ! 😉

Dans la série “je teste pour vous pour que vous n’ayez pas à le faire”, j’ai essayé de faire tourner le gros modèle llama3:70b en local sur mon MacBook Pro. Résultat, je lance un prompt et la réponse commence après 5 minutes d’attente et chaque mot met plusieurs dizaines de secondes à apparaître 😂.

Donc, ne le faites pas.

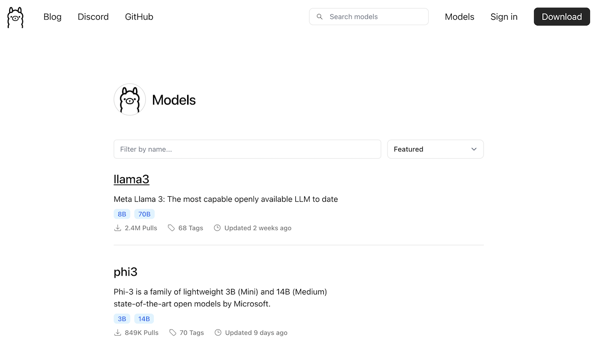

Cela dit, pour ceux qui ont un Mac, n’oubliez pas qu’avec Ollama, il n’y a rien de plus simple que de faire tourner localement un agent conversationnel… mais plus petit donc ! Avec Llama3:8b ou Mistral:7b, les réponses ne demandent que quelques secondes, sans avoir besoin de faire tourner d’immenses centres serveurs voraces en énergie.